前言

任何数据量大的情况下,取数据的时候都需要做分页的处理,比如我们百度的时候,结果往往有上千万的结果,而当前呈现在的只有几页的内容,这就是分页的场景,lucene也提供了分页查询的支持

认识searchafter

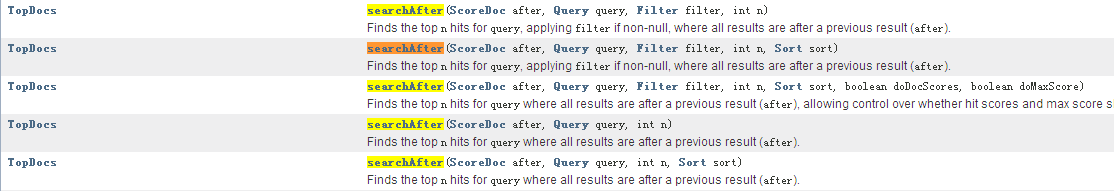

使用IndexSearcher的searchafter方法可以轻松实现分页查询,如下图

searchafter有多个重载的方法,其中有些searchafter方法Lucene已不推荐使用了,用的多的就searchAfter(final ScoreDoc after, Query query, int numHits)

它有三个形参,分别是

after:上一页最后一个ScoreDoc;

query:query接口实现类的对象,query对象可以通过QueryParser类来创建,也可以自己new Query接口的某一个特定接口实现类;

numHits:每页显示的条数

重点在下面

/**

* Created by 小陈 on 2016/3/25.

*/

public class IndexerPaging {

//测试数据,模拟数据库表结构

private static String[] ids={"1","2","3","4","5","6"}; //用户ID

private static String [] names={"kl","kl","kl","kl","kl","fds"};

private static String [] describes={"shi yi ge mei nan zi","Don't know","Is an idiot\n","Is an idiot\n","Is an idiot\n","Is an idiot\n"};

//索引存储地址

private static String indexDir="E:\\javaEEworkspace\\LuceneDemo\\LuceneIndex";

/**

* 获取操作索引实体,并添加测试数据

* @param indexDir 索引存储位置

* @return

* @throws Exception

*/

public static void getIndexWriter(String indexDir)throws Exception{

IndexWriterConfig writerConfig=new IndexWriterConfig(getAnalyzer());

IndexWriter indexWriter=new IndexWriter(FSDirectory.open(Paths.get(indexDir)),writerConfig);

Document document=new Document();

//Field.Store.YES或者NO(存储域选项)

//设置为YES表示或把这个域中的内容完全存储到文件中,方便进行文本的还原

//设置为NO表示把这个域的内容不存储到文件中,但是可以被索引,此时内容无法完全还原(doc.get)

for(int i=0;i1){

int pageIndexLast=(pageIndex-1)*pageSize-1;

TopDocs hits=searcher.search(query,pageIndexLast);

if(hits.totalHits>=pageIndexLast)

return hits.scoreDocs[pageIndexLast];

}

return null;

}

public static void searcher(String indexDir,String q,int pageIndex,int pageSize)throws Exception{

Directory directory= FSDirectory.open(Paths.get(indexDir));

IndexReader reader= DirectoryReader.open(directory);

IndexSearcher indexSearcher=new IndexSearcher(reader);

QueryParser queryParser=new QueryParser("names",new StandardAnalyzer());

Query query=queryParser.parse(q);

//分页查询

TopDocs hits= indexSearcher.searchAfter(getPageLastScoreDoc(pageIndex,pageSize,query,indexSearcher),query,pageSize);//查询首次的30条

System.out.println("匹配 "+q+"查询到"+hits.totalHits+"个记录");

for (ScoreDoc scoreDoc:hits.scoreDocs){

Document doc=indexSearcher.doc(scoreDoc.doc);

System.out.println(doc.get("describes"));//打印Document的fileName属性

}

reader.close();

directory.close();//关闭连接

}

/**

* 得到默认分词器

* @return

*/

public static Analyzer getAnalyzer(){

return new StandardAnalyzer();

}

@Test

public void Test()throws Exception{

// getIndexWriter(indexDir);

searcher(indexDir,"kl",1,10);//查询测试

}

}